Los ciberdelincuentes utilizan nuevas técnicas para distribuir desnudos falsos a partir de contenidos publicados en las redes sociales

El Oficina Federal de Investigaciones de los Estados Unidos (FBI) alertó que los ciberdelincuentes utilizan la técnica de ‘falso profundo‘ del contenido publicado en las redes sociales para hostigar y extorsionar a las víctimas.

El nombre de falso profundo viene de aprendizaje profundotraducido como aprendizaje profundo, una de las corrientes de la Inteligencia Artificial (IA).

En este caso, es el Aprendizaje de IA utilizado con la intención de crear contenido falso.

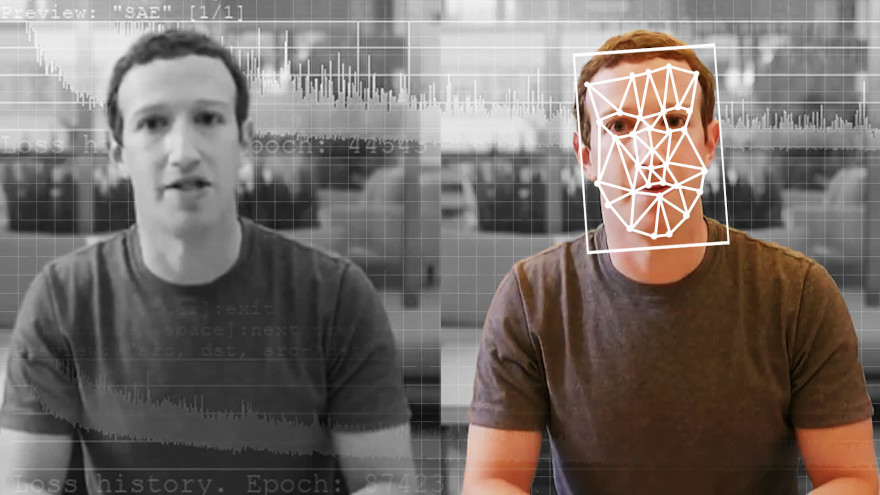

En la mayoría de los casos, esto se basa en manipulaciones de video en el que el software analiza el material de origen y extrae parte de él.

Luego lo inserta y lo adapta a otro video. Los llamados intercambios de rostros o retratos en video profundo son la forma más común de falsificación.

Cada vez parece más difícil detectar qué es real y qué no. Esto no quiere decir que sea imposible, incluso el falsificaciones profundas mejor trabajada puede ser detectada por especialistas en técnicas de transferencia de estilo.

Deep Fake, una preocupante realidad: los ciberdelincuentes crean vídeos falsos para extorsionar

Deep fake: ¿Cómo funciona la técnica?

Este método funciona mediante un algoritmo de inteligencia artificial llamado codificador donde se ejecutan miles de tomas de la cara de las personas que quieren falsificar.

Lo que hace el codificador es identificar y aprender similitudes entre caras y los reduce a características comunes compartidas a través de un proceso de compresión de la imagen.

Entonces un segundo algoritmo llamado descifradorque se encarga de recuperar las imágenes comprimidas.

Para realizar el intercambio de rostros, las imágenes codificadas se introducen en el decodificador contrario para que reconstruya el rostro de la otra persona.

Es decir, una imagen codificada del enfrenta un se alimenta al decodificador entrenado en la cara B.

El decodificador se encarga de reconstruir la cara B con las expresiones y orientación de la cara A para obtener una imagen convincente.

El Deep fake es un método que se perfecciona cada día y complica la vida de miles de personas

¿Cuáles fueron los primeros Deep Fake?

En 2018, esta técnica comenzó a sonar con frecuencia a partir de su uso en videos de contenido sexual, aunque la innovación comenzó en 2014.

En 2017, un usuario anónimo de Reddit Yo uso el aprendizaje profundo para intercambiar las caras de actrices famosas con las de las actrices originales en escenas de películas para adultos.

En 2014, Ian Goodfellow, estudiante de doctorado en la Universidad de Montrealfue pionera en la generación de imágenes con el enfoque de redes neuronales generativas antagónicas, GAN.

buen compañero entrenó dos redes neuronales con la misma base de datos de imágenes y luego creó otras nuevas. Enfrentó las dos redes entre sí para identificar qué imágenes eran reales y cuáles ficticias como un juego digital del gato y el ratón.

El primer modelo de red neuronal generó nuevas imágenes a partir de la base de datos que había aprendido al crear, por ejemplo, un gato con dos colas.

El segundo modelo detectó las imágenes ficticias y, por lo tanto, el primer modelo aprendió de sus propios errores y generó gatos con una sola cola. Poco a poco se fueron creando imágenes cada vez más realistas y difíciles de distinguir.

Estas técnicas de inteligencia artificial utilizado por los equipos de investigación para generar caras ficticias a partir de imágenes de celebridades o para crear pinturas supuestamente hechas por van Gogh.

Originalmente, estas redes neuronales cometieron una gran cantidad de errores, como bicicletas con dos manillares o rostros con cejas mal colocadas.

Sin embargo, actualmente son capaces de crear con una imagen completa con alto nivel de plausibilidad de una parte de él: por ejemplo, el cuerpo de un gato de su cabeza.